Robots.txt e SEO: tudo o que você precisa saber

Resumo (TL;DR)

O arquivo Robots.txt é um elemento fundamental na estrutura de um site, responsável por instruir os motores de busca sobre quais páginas ou arquivos podem ser rastreados e indexados.

Embora seja simples de configurar, um erro no arquivo Robots.txt pode resultar em grandes problemas para o SEO, como impedir que o Google e outros motores de busca encontrem e mostrem o conteúdo do seu site.

Este guia aborda desde a importância e o propósito do Robots.txt, como criá-lo, as melhores práticas, até a verificação de erros comuns e perguntas frequentes, garantindo que seu site esteja otimizado para os motores de busca.

Acesso rápido

- 1. O que é um arquivo Robots.txt

- 2. Como reconhecer um arquivo Robots.txt

- User-agent

- Diretivas

- 3. Você realmente precisa de um arquivo Robots.txt?

- 4. Como encontrar o arquivo Robots.txt do seu site

- 5. Como criar um arquivo Robots.txt

- 6. Quais são as boas práticas de uso do arquivo Robots.txt

- 7. Exemplos de arquivos Robots.txt

- 8. Como encontrar erros em um arquivo Robots.txt

- 9. FAQs

- Considerações Finais

O Robots.txt é um dos arquivos mais simples dentro de um site. Mas também pode ser um dos mais problemáticos.

Isso acontece porque uma simples troca de um caractere pode fazer com que o Google não encontre mais o seu conteúdo para mostrar aos usuários. Dessa forma, isso vai prejudicar muito o SEO que você construiu.

Pensando na importância deste assunto, neste texto você vai aprender sobre:

- O que é um arquivo Robots.txt

- Como reconhecer um arquivo Robots.txt

- Você realmente precisa de um arquivo Robots.txt?

- Como encontrar o arquivo Robots.txt do seu site

- Como criar um arquivo Robots.txt

- Quais são as boas práticas de uso do arquivo Robots.txt

- Exemplos de arquivos Robots.txt

- Como encontrar erros em um arquivo Robots.txt

- FAQs

1. O que é um arquivo Robots.txt

O Robots.txt é um arquivo hospedado na raiz de um site. Este arquivo de texto conta com instruções, direcionadas aos robôs do Google e outros buscadores.

Neste arquivo você deve informar três pontos principais:

- Quais diretórios não devem ser rastreados pelos motores de busca;

- Arquivos que não devem ser indexados;

- O mapa do site com as URLs que devem ser rastreadas pelo Google.

Considerando todas essas informações, um arquivo Robots.txt não revisado é um grande risco. O que acontece é que o site pode acabar não aparecendo para os usuários.

Isso porque quando o site está sendo criado, os programadores adicionam a seguinte configuração ao Robots.txt:

User-agent: *

Disallow: /

Nesse caso, o arquivo está dizendo para todos os robôs (user-agent: *) que não realizem o rastreamento de páginas do site (com o comando disallow: /). Por isso, quando o site for lançado essa instrução precisa ser alterada. Caso contrário o site não será encontrado.

O Google tem uma página dedicada ao Robots.txt, acesse clicando aqui.

2. Como reconhecer um arquivo Robots.txt

Um arquivo Robots.txt é escrito da seguinte forma:

Sitemap: [URL location of sitemap]

User-agent: [bot identifier]

[directive 1]

[directive 2]

[directive …]

User-agent: [another bot identifier]

[directive 1]

[directive 2]

[directive …]

Em resumo, o que deve ser feito é adicionar regras para os robôs determinando qual é o user-agent e quais são as diretivas.

User-agent

O user-agent é o campo no qual você deve definir para qual robô a regra na sequência deverá ser aplicada. Por padrão, esta será sempre a primeira linha de qualquer regra. Caso você queira incluir todos os robôs em uma única regra, deve utilizar o símbolo *.

Os user-agents mais importantes para SEO são:

- Google: Googlebot

- Google Images: Googlebot-Image

- Bing: Bingbot

- Yahoo: Slurp

- Baidu: Baiduspider

- DuckDuckGo: DuckDuckBot

Importante: A cada novo user-agent adicionado, é preciso adicionar as diretivas novamente. Afinal, as instruções relacionadas ao primeiro user-agent não se aplicam para outros adicionados posteriormente.

Diretivas

Na sequência devem ser adicionadas as diretivas, que são as regras que você quer dar aos user-agents.

Diretivas reconhecidas pelo Google

Entenda abaixo quais são as diretivas que o Google reconhece.

Disallow (desabilitar)

Ao utilizar esta diretiva, você cria uma instrução para que os motores de busca não acessem os arquivos e páginas naquele caminho específico.

Se você não quiser que usuários acessem o seu blog e todos os seus posts, deve adicionar ao arquivo a seguinte diretiva:

User-agent: *

Disallow: /blog

Allow (habilitar)

Por outro lado, a diretiva ‘allow’ é utilizada para que os motores de busca possam rastrear um diretório ou página – mesmo que esta tenha sido desabilitada antes.

No exemplo temos um caso em que o dono do site não quer que os usuários visualizem o blog e seus posts. A intenção que é apenas post específico possa ser acessado. Neste caso o robots.txt ficará assim:

User-agent: *

Disallow: /blog

Allow: /blog/allowed-post

Com isso, os motores de busca como Google e Bink conseguirão acessar o endereço “/blog/allowed-post”, mas não conseguirão acessar outros:

Exemplo:

- /blog/another-post

- /blog/yet-another-post

- /blog/download-me.pdf

Sitemap (mapa do site)

Esta diretiva é utilizada para que os motores de busca localizem o sitemap criado no robots.txt. Um sitemap inclui páginas que você quer que os buscadores rastreiem e indexem.

Abaixo segue um exemplo de um arquivo com a diretiva de sitemap. Perceba que este não precisa ser repetido sempre que você cita um novo user-agent:

Sitemap: https://www.domain.com/sitemap.xml

User-agent: Googlebot

Disallow: /blog/

Allow: /blog/post-title/

User-agent: Bingbot

Disallow: /services/

Diretivas não reconhecidas pelo Google

Agora entenda duas diretivas não reconhecidas pelo Google.

Noindex

Acreditava-se que a tag noindex era reconhecida informalmente pelo Google. Contudo, em 1º de Setembro de 2019 a empresa confirmou que não reconhece essa diretiva.

A tag noindex era usada para impedir que o Google realizasse a indexação de todos os posts em um blog:

User-agent: Googlebot

Noindex: /blog/

Nofollow

A tag nofollow também nunca foi uma diretiva oficial do Google para o robots.txt. E em 1º de Setembro de 2019, a empresa também afirmou que uma opção para o nofollow no robots.txt era adicionar o atributo rel=“nofollow” em cada URL citada em uma página.

Mas originalmente muitas pessoas acreditavam ser possível bloquear os links em um blog através da seguinte diretiva:

User-agent: Googlebot

Nofollow: /blog/

3. Você realmente precisa de um arquivo Robots.txt?

Se o seu site é pequeno, há uma grande chance de você não precisar do arquivo Robots.txt. Mas para quem possui, o robots.txt é importante para controlar quais páginas do seu site os motores de busca podem acessar.

Com o uso dele é possível:

- Evitar ranqueamento de conteúdo duplicado;

- Manter certas seções do site privadas;

- Evitar sobrecarga de servidores;

- Evitar que imagens, vídeos e arquivos sejam disponibilizados nos resultados do Google.

Mas entenda que ele não elimina completamente os resultados na internet sobre determinado conteúdo. O que pode acontecer é o seu site estar linkado em outros sites, e estes podem aparecer em uma pesquisa do Google indiretamente.

4. Como encontrar o arquivo Robots.txt do seu site

Se você já tem um arquivo robots.txt no seu site, este será exibido ao digitar “seusite.com.br/robots.txt” na barra de pesquisa da internet.

Se algo assim aparecer, é porque você tem um arquivo robots.txt:

Faça um teste com o endereço https://www.google.com.br/robots.txt e veja os resultados.

Robots.txt

5. Como criar um arquivo Robots.txt

Se você ainda não tem o seu arquivo robots.txt, não é difícil criar um. O que você precisa é:

- Criar um arquivo de bloco de notas (.txt) em branco, e começar a digitar as diretivas.

Se você quiser que os buscadores não encontrem o seu diretório de /admin/, você deve digitar:

User-agent: *

Disallow: /admin/

- Crie todas as diretivas que você precisar.

- Salve o arquivo como “robots.txt.”

Onde colocar o arquivo finalizado?

O seu arquivo robots.txt deve ser adicionado à raiz do seu site, mais especificamente na raiz do subdomínio para o qual o arquivo se aplica.

Por exemplo, para controlar o comportamento de rastreamento das páginas em “seusite.com.br”, o arquivo deve ser acessível através do endereço “seusite.com.br/robots.txt”

6. Quais são as boas práticas de uso do arquivo Robots.txt

Entenda agora quais são as boas práticas de uso robots.txt para evitar problemas de SEO e erros:

Utilize uma nova linha para cada diretiva

Incorreto:

User-agent: * Disallow: /directory/ Disallow: /another-directory/

Correto:

User-agent: *

Disallow: /directory/

Disallow: /another-directory/

Utilize o símbolo * para simplificar instruções gerais

Quando você quer incluir todos os user-agents e vários comandos de Disallow em uma diretiva, é possível utilizar * para isso. Veja abaixo:

Opção menos eficiente

User-agent: *

Disallow: /products/t-shirts?

Disallow: /products/hoodies?

Disallow: /products/jackets?

…

Opção mais eficiente

User-agent: *

Disallow: /products/*?

Dessa forma, se a intenção é bloquear todas as páginas de produtos, você pode criar apenas um comando geral. E assim elimina a necessidade de digitar todas as subcategorias dentro desse grande item do site.

Utilize “$” para especificar o fim de uma URL

Se você quer bloquear a busca por todos os perfis que terminem em .pdf no seu site, pode usar a diretiva abaixo:

User-agent: *

Disallow: /*.pdf$

Dessa forma todas as URL que terminem em PDF serão bloqueadas. Mas no caso de páginas que contém PDF na URL, sem terminar a URL nesse ponto (/file.pdf?id=68937586), continuam aparecendo na busca.

Cada user-agent deve ser utilizado apenas uma vez

Para que você evite erros, esta boa prática é indicada. Afinal, o Google vai conseguir entender se você citar um user-agent diversas vezes. O problema é que você tem grandes chances de repetir ou esquecer de alguma informação dessa forma.

Mantenha as diretivas específicas para evitar os erros simples

Se você criar uma diretiva muito aberta, poderá ter seu SEO prejudicado. Por exemplo, vamos considerar que um site está lançando uma versão em Alemão, mas ainda não tem todo o conteúdo pronto.

Para evitar que os motores de busca mostrem uma página inacabada, é possível adicionar a seguinte diretiva:

User-agent: *

Disallow: /de

Mas perceba que esta diretiva também vai acabar bloqueando qualquer pesquisa que comece com “/de”:

- /designer-dresses/

- /delivery-information.html

- /depeche-mode/t-shirts/

- /definitely-not-for-public-viewing.pdf

Por isso, você deve adicionar uma “ / ” final à diretiva:

User-agent: *

Disallow: /de/

Comunique-se através de comentários no robots.txt

Você pode se comunicar com os desenvolvedores do site, ou até mesmo deixar comentários para alterações futuras. Para incluir um comentário no robots.txt é preciso adicionar o símbolo # antes de começar a frase.

Utilize um robots.txt para cada subdomínio

Se você tiver um site “seusite.com.br” e um blog “blog.seusite.com.br”, é preciso criar dois arquivos robots.txt. Cada arquivo deve ser adicionado na raiz de cada domínio.

7. Exemplos de arquivos Robots.txt

Se você não sabe muito bem das possibilidades que existem em um arquivo robots.txt, compartilhamos abaixo alguns exemplos usados.

Acesso total para todos os user-agents

User-agent: *

Disallow:

Acesso totalmente bloqueado para todos os user-agents

User-agent: *

Disallow: /

Bloquear uma pasta de todos os user-agents

User-agent: *

Disallow: /folder/

Bloquear um arquivo de todos os user-agents

User-agent: *

Disallow: /this-is-a-file.pdf

Bloquear um arquivo de PDF de todos os user-agents

User-agent: *

Disallow: /*.pdf$

8. Como encontrar erros em um arquivo Robots.txt

Como você percebeu durante este texto, são diversos detalhes que devem ser considerados ao escrever um arquivo robots.txt. Assim, entenda como encontrar erros nestes arquivos.

Para essa auditoria, é interessante fazer uma verificação periódica por problemas relacionados no Robots.txt através do Relatório de Cobertura do Google Search Console.

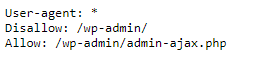

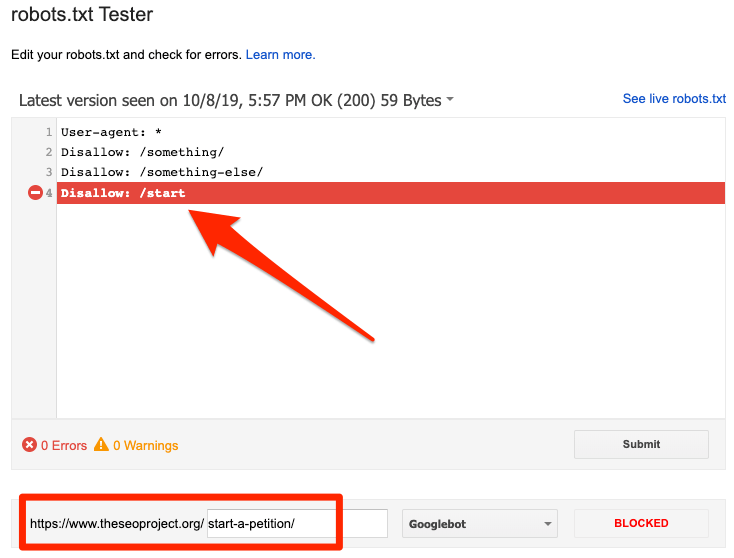

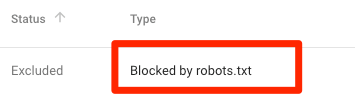

- Digite a URL na Ferramenta de Inspeção de URL do Google Search Console. Se esta página estiver bloqueada no robots.txt você deverá encontrar uma tela assim:

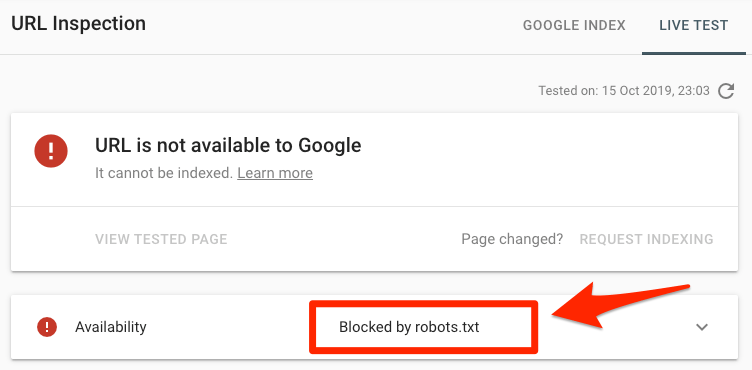

- Se alguma URL do seu sitemap está bloqueada, você verá esta tela:

Se você criar um sitemap correto e excluiu canonicalização, noindex e redirects, este erro não deveria aparecer.

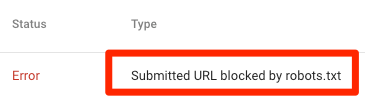

Para avaliar exatamente a diretiva que acabou bloqueando algum conteúdo indevidamente, utilize o suporte do Google na ferramenta testar robots.txt. Veja abaixo uma tela da ferramenta:

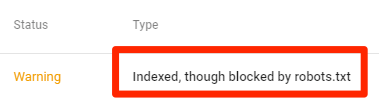

- Se você encontrar o erro abaixo, significa que algum conteúdo não indexado pelo Google foi bloqueado pelo robots.txt

Assim, se você tiver utilizado o robots.txt com a intenção de excluir uma página do Google, existem outras opções que podem ser realizadas.

- Robots meta tag;

- Cabeçalho HTTP X-Robots-Tag.

Somente com estas estratégias é que uma página pode ser desindexada do Google.

- Quando algum conteúdo bloqueado pelo robots.txt ainda está indexado ao Google.

Este é mais um problema relacionado ao uso do arquivo para excluir páginas. Como já vimos acima, existem outras opções para isso.

9. FAQs

Para finalizar este material sobre o Robots.txt e SEO, vamos citar algumas das perguntas mais frequentes sobre o assunto:

Qual o tamanho total do arquivo?

500 kilobytes (aproximadamente).

Onde encontrar o robots.txt no WordPress?

No mesmo lugar de outras plataformas de sites e blogs: fazendo uma busca por seusite.com.br/robots.txt.

Como editar o robots.txt no WordPress?

Você pode fazer isso manualmente, ou então utilizando os plugins de SEO do WordPress como o Yoast.

Considerações Finais

Chegamos ao fim do conteúdo com todas as informações que você precisa saber sobre o robots.txt. Como você reparou, em diversos momentos citamos que pequenos erros no arquivo podem acabar gerando grandes problemas para o SEO do seu site.

Por isso, é essencial que você observe as boas práticas citadas acima, evite erros desnecessários e mantenha seu robots.txt bem organizado.

PERGUNTAS FREQUENTES

O que é o arquivo Robots.txt e qual sua função principal?

O Robots.txt é um arquivo de texto simples localizado na raiz de um site, que fornece instruções aos robôs dos motores de busca sobre quais páginas ou arquivos devem ou não ser rastreados e indexados. Ele é essencial para controlar a visibilidade do seu conteúdo nos motores de busca.

Como posso criar e configurar um arquivo Robots.txt?

Para criar um Robots.txt, basta criar um arquivo de texto (.txt), adicionar as diretivas necessárias (como Disallow para bloquear páginas e Allow para permitir o rastreamento), e salvá-lo como robots.txt na raiz do seu site. É importante garantir que as diretivas sejam precisas para evitar problemas de SEO.

Quais são as boas práticas ao usar o Robots.txt?

Algumas boas práticas incluem: utilizar uma nova linha para cada diretiva, usar o símbolo * para generalizar instruções, empregar o símbolo $ para especificar o fim de uma URL, e manter o arquivo organizado com comentários explicativos. Isso ajuda a evitar erros e a garantir que o arquivo funcione como esperado.

Como posso verificar se há erros no meu arquivo Robots.txt?

Você pode utilizar o Google Search Console para verificar se o seu Robots.txt está bloqueando indevidamente alguma URL importante. A ferramenta “Testar Robots.txt” do Google também permite simular o comportamento do arquivo e identificar erros ou bloqueios desnecessários, ajudando a corrigir problemas rapidamente.

Calcular valor agora

Calcular valor agora